Konfronterar nvlink?Tekniska jättar som Intel, AMD, Microsoft och Broadcom bildar Ualink

Åtta tekniska jättar, inklusive Intel, Google, Microsoft och META, etablerar en ny branschgrupp som kallas Ualink -marknadsföringsgruppen för att vägleda utvecklingen av komponenter som ansluter AI -acceleratorchips inom datacentra.

Ualink -marknadsföringsteamet tillkännagavs att upprättas på torsdag, och dess medlemmar inkluderar också AMD, HP Enterprise, Broadcom och Cisco.Gruppen har föreslagit en ny branschstandard för att ansluta ett ökande antal AI -acceleratorchips i servrar.I bred mening är en AI-accelerator ett chip utformat från en GPU till en anpassad lösning för att påskynda träning, finjustering och drift av AI-modeller.

"Branschen behöver en öppen standard som snabbt kan drivas framåt, vilket gör att flera företag kan ge mervärde till hela ekosystemet i ett öppet format.""Branschen behöver en standard som gör det möjligt för innovation att äga rum i snabb takt utan att begränsas av ett enda företag", säger Forrest Norrod, chef för AMD Data Center Solutions, i en briefing på onsdag

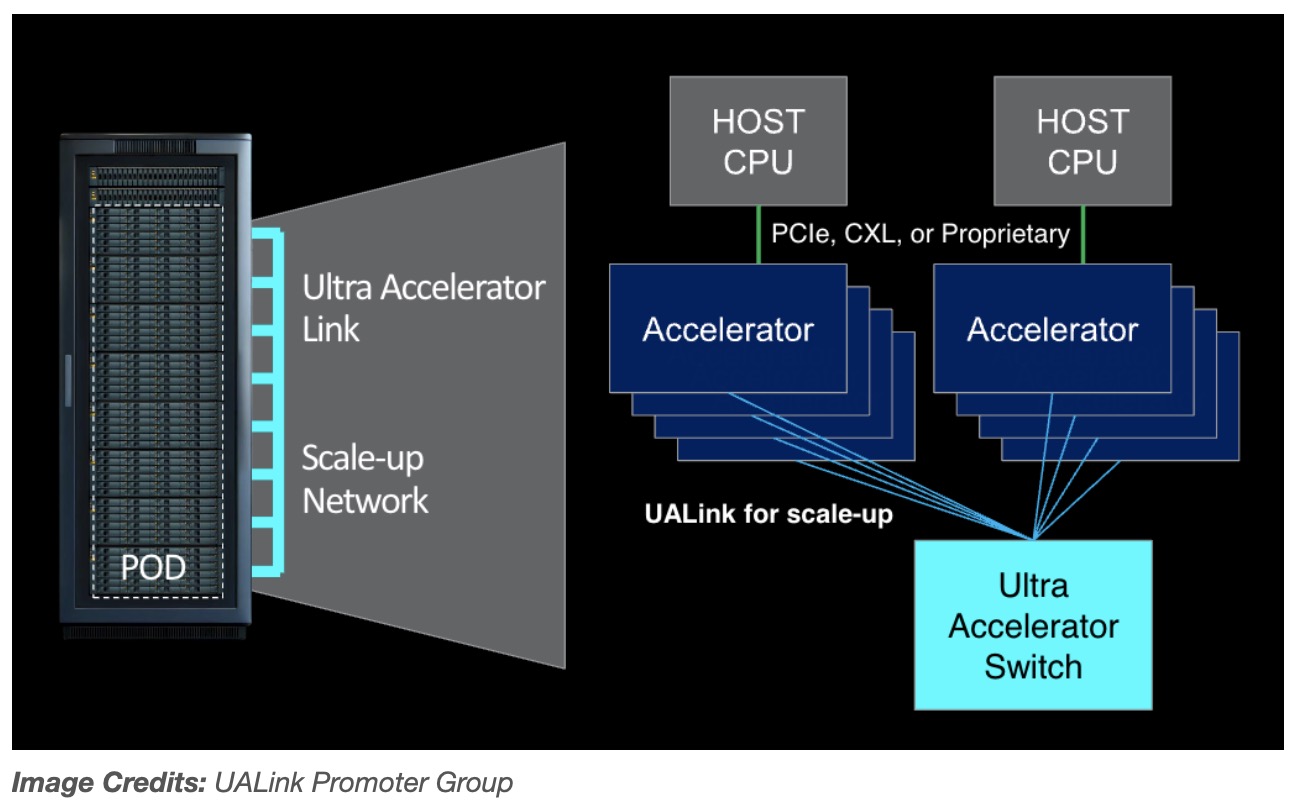

Den första versionen av den föreslagna standarden, Ualink 1.0 , upp till 1024 AI -acceleratorer kommer att anslutas i en enda datorpod - GPU.(Gruppen definierar POD som ett eller flera rack på en server.) Ualink 1.0 är baserad på "öppna standarder" och inkluderar AMD: s oändliga arkitektur.Det kommer att möjliggöra direkt belastning och lagring av ytterligare minne mellan AI -acceleratorer, och totalt sett förbättra hastigheten och minska dataöverföringslatensen jämfört med befintliga sammankopplingsspecifikationer.

Gruppen uppgav att den kommer att skapa en allians, Ualink -alliansen, under det tredje kvartalet för att övervaka den framtida utvecklingen av Ualink -standarder.Ualink 1.0 kommer att tillhandahållas till företag som ansluter sig till alliansen under samma period, med en högre bandbredduppdateringsspecifikation för Ualink 1.1.Det är planerat att lanseras under det fjärde kvartalet 2024.

Den första omgången av Ualink -produkter kommer att lanseras "under de kommande åren", sa Norrod.

NVIDIA, den största AI -acceleratortillverkaren hittills, med en uppskattad marknadsandel på 80 till 95%, är tydligt frånvarande från listan över medlemmar i gruppen.Nvidia vägrade att kommentera detta.Men det är inte svårt att se varför denna chiptillverkare inte är angelägen om att stödja specifikationer baserade på konkurrentteknologi.

För det första tillhandahåller NVIDIA sin egen äganderättsteknologi för GPU: er inom sina datacenterservrar.Företaget kanske inte är villigt att stödja standarder baserat på konkurrentteknologi.

Sedan kommer det faktum att Nvidia arbetar från en position av enorm styrka och inflytande.

I NVIDIA: s senaste finansiella kvartal (Q1 2025) ökade datacenterförsäljningen, inklusive dess AI -chipförsäljning, med över 400% jämfört med samma period förra året.Om NVIDIA fortsätter sin nuvarande utvecklingsbana kommer den att överträffa Apple någon gång i år att bli världens mest värdefulla företag.

Därför, i enkla termer, om Nvidia inte vill delta, behöver den inte delta.

När det gäller Amazon Web Services (AWS), som är den enda offentliga molngiganten som inte har bidragit till Ualink, kan det vara i ett vänta-och-se-läge eftersom det minskar sina olika interna acceleratorhårdvaruinsatser.Det kan också vara AWS, förlita sig på sin kontroll över molntjänstmarknaden och inte se någon strategisk betydelse för att motsätta sig Nvidia, vilket gav de flesta av sina GPU: er till sina kunder.

AWS svarade inte på TechCrunchs kommentarförfrågan.

Faktum är att de största mottagarna av Ualink - bortsett från AMD och Intel - verkar vara Microsoft, Meta och Google, som har spenderat miljarder dollar för att köpa NVIDIA GPU: er för att driva sina moln och träna sina växande AI -modeller.Alla vill bli av med en leverantör som de ser som alltför dominerande i AI -hårdvaruekosystemet.

Google har anpassade chips, TPU och axion för träning och körning av AI -modeller.Amazon har flera AI -chipfamiljer.Microsoft gick med i tävlingen mellan Maia och Cobalt förra året.Meta förbättrar sin acceleratorserie.

Samtidigt planerar Microsoft och dess nära partner OpenAI enligt uppgift att spendera minst 100 miljarder dollar på en superdator för att utbilda AI -modeller, som kommer att vara utrustade med framtida kobolt- och MAIA -chips.Dessa chips kommer att behöva något för att ansluta dem - kanske kommer det att vara Ualink.

"Branschen behöver en öppen standard som snabbt kan drivas framåt, vilket gör att flera företag kan ge mervärde till hela ekosystemet i ett öppet format.""Branschen behöver en standard som gör det möjligt för innovation att äga rum i snabb takt utan att begränsas av ett enda företag", säger Forrest Norrod, chef för AMD Data Center Solutions, i en briefing på onsdag

Den första versionen av den föreslagna standarden, Ualink 1.0 , upp till 1024 AI -acceleratorer kommer att anslutas i en enda datorpod - GPU.(Gruppen definierar POD som ett eller flera rack på en server.) Ualink 1.0 är baserad på "öppna standarder" och inkluderar AMD: s oändliga arkitektur.Det kommer att möjliggöra direkt belastning och lagring av ytterligare minne mellan AI -acceleratorer, och totalt sett förbättra hastigheten och minska dataöverföringslatensen jämfört med befintliga sammankopplingsspecifikationer.

Gruppen uppgav att den kommer att skapa en allians, Ualink -alliansen, under det tredje kvartalet för att övervaka den framtida utvecklingen av Ualink -standarder.Ualink 1.0 kommer att tillhandahållas till företag som ansluter sig till alliansen under samma period, med en högre bandbredduppdateringsspecifikation för Ualink 1.1.Det är planerat att lanseras under det fjärde kvartalet 2024.

Den första omgången av Ualink -produkter kommer att lanseras "under de kommande åren", sa Norrod.

NVIDIA, den största AI -acceleratortillverkaren hittills, med en uppskattad marknadsandel på 80 till 95%, är tydligt frånvarande från listan över medlemmar i gruppen.Nvidia vägrade att kommentera detta.Men det är inte svårt att se varför denna chiptillverkare inte är angelägen om att stödja specifikationer baserade på konkurrentteknologi.

För det första tillhandahåller NVIDIA sin egen äganderättsteknologi för GPU: er inom sina datacenterservrar.Företaget kanske inte är villigt att stödja standarder baserat på konkurrentteknologi.

Sedan kommer det faktum att Nvidia arbetar från en position av enorm styrka och inflytande.

I NVIDIA: s senaste finansiella kvartal (Q1 2025) ökade datacenterförsäljningen, inklusive dess AI -chipförsäljning, med över 400% jämfört med samma period förra året.Om NVIDIA fortsätter sin nuvarande utvecklingsbana kommer den att överträffa Apple någon gång i år att bli världens mest värdefulla företag.

Därför, i enkla termer, om Nvidia inte vill delta, behöver den inte delta.

När det gäller Amazon Web Services (AWS), som är den enda offentliga molngiganten som inte har bidragit till Ualink, kan det vara i ett vänta-och-se-läge eftersom det minskar sina olika interna acceleratorhårdvaruinsatser.Det kan också vara AWS, förlita sig på sin kontroll över molntjänstmarknaden och inte se någon strategisk betydelse för att motsätta sig Nvidia, vilket gav de flesta av sina GPU: er till sina kunder.

AWS svarade inte på TechCrunchs kommentarförfrågan.

Faktum är att de största mottagarna av Ualink - bortsett från AMD och Intel - verkar vara Microsoft, Meta och Google, som har spenderat miljarder dollar för att köpa NVIDIA GPU: er för att driva sina moln och träna sina växande AI -modeller.Alla vill bli av med en leverantör som de ser som alltför dominerande i AI -hårdvaruekosystemet.

Google har anpassade chips, TPU och axion för träning och körning av AI -modeller.Amazon har flera AI -chipfamiljer.Microsoft gick med i tävlingen mellan Maia och Cobalt förra året.Meta förbättrar sin acceleratorserie.

Samtidigt planerar Microsoft och dess nära partner OpenAI enligt uppgift att spendera minst 100 miljarder dollar på en superdator för att utbilda AI -modeller, som kommer att vara utrustade med framtida kobolt- och MAIA -chips.Dessa chips kommer att behöva något för att ansluta dem - kanske kommer det att vara Ualink.